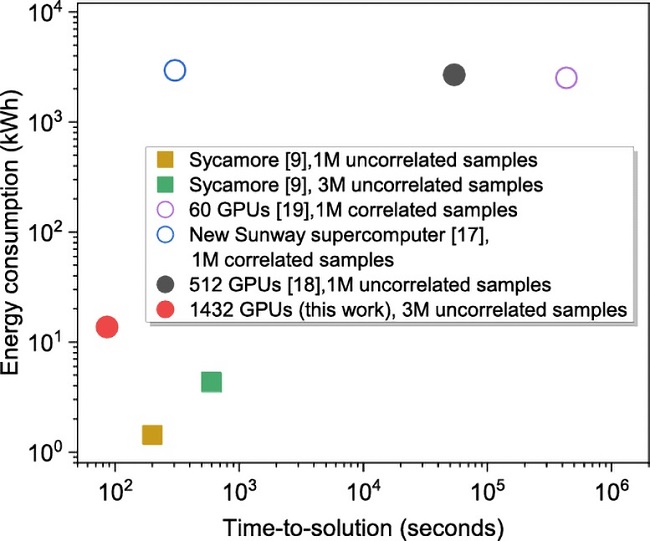

محققان با استفاده از ۱۴۳۲ پردازنده گرافیکی انویدیا A100 و الگوریتمهای پیشرفته، موفق به شبیهسازی دقیق مدار کوانتومی ۵۳ کیوبیتی Sycamore گوگل شدند. این دستاورد مرزهای توانایی کامپیوترهای کلاسیک در شبیهسازی سیستمهای کوانتومی پیچیده را جابجا میکند و هزینه طراحی کامپیوترهای کوانتومی را کاهش میدهد.

تیمی از محققان به نقطه عطف مهمی در حوزه محاسبات کوانتومی دست یافتهاند. آنها موفق شدند مدار کوانتومی پیچیده Sycamore گوگل، با ۵۳ کیوبیت و ۲۰ لایه عملیاتی، را با استفاده از توان محاسباتی ۱۴۳۲ پردازنده گرافیکی انویدیا A100 و الگوریتمهای موازی بهینهشده، شبیهسازی کنند. این موفقیت نه تنها توانایی سیستمهای کلاسیک را به نمایش میگذارد، بلکه درهای جدیدی را برای شبیهسازی سیستمهای کوانتومی پیشرفته روی سختافزارهای امروزی باز میکند.

نوآوری در الگوریتمهای شبکه تانسوری

هسته اصلی این دستاورد، استفاده از تکنیکهای پیشرفته «شبکه تانسوری» (Tensor Network) است. این روشها به طور موثری احتمال خروجیهای مدارهای کوانتومی را تخمین میزنند. برای ممکن ساختن شبیهسازی در این مقیاس، محققان از روشی به نام «برشزنی» استفاده کردند تا شبکه تانسوری کامل را به بخشهای کوچکتر و قابل مدیریت تقسیم کنند. این رویکرد به طور قابل توجهی نیاز به حافظه را کاهش داد، که باعث شد شبیهسازی مدارهای کوانتومی بزرگ با منابع سختافزاری به مراتب کمتر را متر امکانپذیر شود.

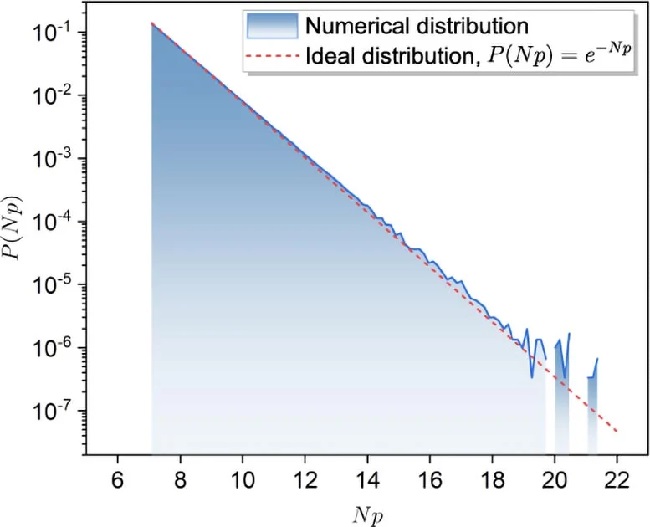

علاوه بر این، تیم تحقیقاتی از روش نمونهبرداری «top-k» بهره برد که محتملترین رشتههای بیتی را از خروجی شبیهسازی انتخاب میکند. با تمرکز تنها بر نتایجِ با احتمال بالا، آنها توانستند معیار کلیدی Linear Cross-Entropy یا XEB را بهبود بخشند. این بنچمارک نشان میدهد که نتایج شبیهسازی چقدر به رفتار مورد انتظار کوانتومی نزدیک است.

اعتبارسنجی با مدارهای کوچکتر

برای تأیید درستی الگوریتم، محققان آزمایشهای عددی را با مدارهای تصادفی در مقیاس کوچکتر، از جمله یک مدار ۳۰ کیوبیتی با ۱۴ لایه گیت، انجام دادند. نتایج، تطابق بسیار خوبی با مقادیر XEB پیشبینیشده تئوری برای اندازههای مختلف زیرشبکههای تانسوری نشان داد. بهبود مقدار XEB توسط روش top-k نیز با پیشبینیهای نظری همخوانی داشت و دقت و کارایی الگوریتم را تأیید کرد.

این مطالعه همچنین استراتژیهایی را برای بهینهسازی منابع مورد نیاز برای محاسبات تانسوری معرفی کرد. با اصلاح ترتیب شاخصهای تانسور و به حداقل رساندن ارتباطات بین پردازندههای گرافیکی، تیم تحقیقاتی به بهبودهای قابل توجهی در کارایی محاسباتی دست یافت. این استراتژی همچنین، بر اساس تخمینهای پیچیدگی، نشان میدهد که افزایش ظرفیت حافظه مانند میتواند به طور قابل توجهی پیچیدگی زمانی محاسبات را کاهش دهد. در نهایت محاسبات این پروژه با استفاده از پیکربندی حافظه ۸x۸۰ گیگابایت در هر گره محاسباتی، انجام شد.

آینده شبیهسازیهای کوانتومی

این پیشرفت نه تنها معیار جدیدی برای شبیهسازیهای کلاسیک کامپیوترهای کوانتومی چندکیوبیتی ایجاد میکند، بلکه ابزارها و روشهای نوآورانهای را برای تحقیقات آینده در محاسبات کوانتومی معرفی مینماید. محققان انتظار دارند با ادامه اصلاح الگوریتمها و بهینهسازی منابع محاسباتی، پیشرفت قابل توجهی در شبیهسازی مدارهای کوانتومی بزرگتر با کیوبیتهای بیشتر داشته باشند.

نتایج این پروژه در مجله National Science Review منتشر شده است.

در همین رابطه بخوانید:

- چه زمانی میتوانیم از بازار کامپیوتر کوانتومی بخریم؟

- همه چیز درباره رایانش کوانتومی و کاربردهای فوقالعادهای که باید منتظر آنها باشیم

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت