طراحی پردازنده یک فرایند کاملاً تخصصی و سنگین است که با توجه به نیازها و اهداف، میتواند تا چندین ماه برای یک پردازنده کاربردی، به طول انجامد. اما به نظر هوش مصنوعی در این زمینه نیز کمک حال انسان شده است. بنابر اخبار منتشر شده، گروهی از محققان چینی به لطف هوش مصنوعی موفق شدهاند یک پردازنده با معماری RISC-V را که قابل ساخت و کار در دنیای واقعی است، تنها طی 5 ساعت طراحی کنند.

برای طراحی پردازنده به دانش سطح بالا و تجربه گستردهای نیاز است که این روزها به تنهایی و توسط یک مهندس یا دانشمند حوزه سختافزارهای پردازشی میسر نیست. در واقع پردازندهها توسط تیمهایی طراحی میشوند که با کمک یکدیگر روی بخشها و اهداف مختلف کار کرده و در نهایت با تجمیع طرحها، پلتفرم نهایی ساخته و طی چندین مرحله عیب یابی، توسعه و بازسازی، تبدیل به طرح نهایی میشود. طی تمامی این مراحل میتواند فرایندی طولانی باشد و بسته به هدفی که دنبال میشود تا ماهها به طول انجامد و هزاران روز کار نیاز داشته باشد.

اما همانطور که در ابتدای مطلب عنوان شد، گروهی از دانشمندان چینی مقالهای با عنوان «کنار زدن محدودیتهای طراحی ماشین: طراحی خودکار CPU با هوش مصنوعی» منتشر کردهاند که به جزئیات طراحی یک CPU جدید در مقیاس صنعتی با معماری RISC-V و تنها در کمتر از 5 ساعت میپردازد. ادعا می شود که این شاهکار خودکار هوش مصنوعی حدود 1000 برابر سریعتر از یک تیم انسانی است که میتواند یک طراحی CPU قابل مقایسه با این طرح را به پایان برساند.

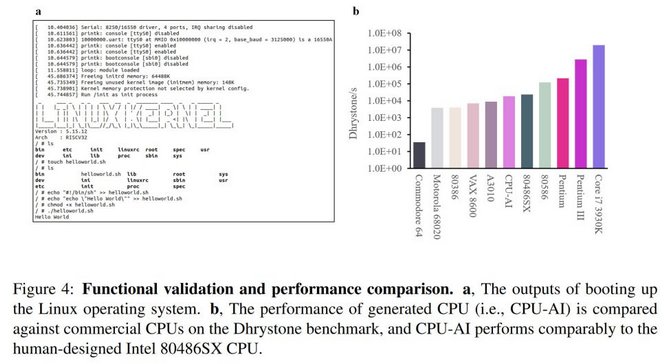

ذکر این نکته حائز اهمیت است که ظاهراً توان پردازشی این پردازنده چندان قابل توجه نیست و با توجه به سرعت و امتیازات کسب شده در تستهای عملی باید گفت که این پردازنده طراحی شده توسط هوش مصنوعی را تنها میتوان با پردازنده اینتل i486 یا همان 80486 مقایسه کرد که در سال 1989 توسط این شرکت معرفی شده و از ساختار آدرسدهی 32 بیتی استفاده مینمود؛ عملکردی که شاید به نظر بسیاری از دانشمندان، مسخره و تنها یک شوخی باشد!

جدای از میزان عملکرد پردازنده ساخته شده هدف تیم تحقیقاتی چینی پاسخ به این سوال بود که آیا ماشینها میتوانند تراشههایی را مانند انسان طراحی کنند؟ این تیم معتقد است که طرحهای قبلی که با هوش مصنوعی ساخته میشدند نسبتاً کوچک یا از نظر دامنه کاربردی بسیار محدود بودهاند. بنابراین، برای آزمایش توان طراحی هوش مصنوعی، ایده طراحی خودکار یک CPU RISC-V دنبال شده که به نتایج عنوان فوق منجر گردیده است.

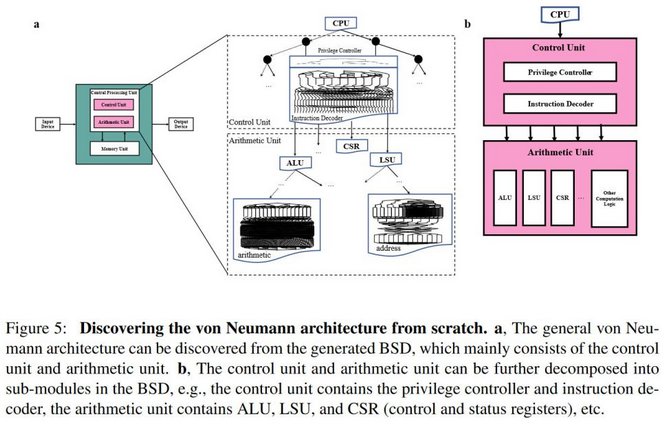

پروژه هایی مانند این طرح معمولاً با ساخت یک پایگاه داده گسترده یا یک دوره یادگیری ماشین شروع میشوند. روند مورد نظر آموزش در این طرح شامل مشاهده یک سری ورودی و خروجی برای پردازنده تعیین شده است. در واقع دانشمندان یک نمودار حدس و گمان دودویی (BSD) را از این ورودی/خروجیها ایجاد کرده و از اصول توسعه مبتنی بر روش تجربه مونت کارلو (یک الگوریتم محاسباتی است که از نمونهگیری تصادفی برای محاسبه نتایج استفاده میکند) و توابع بولی استفاده نمودند تا دقت و کارایی طراحی CPU مبتنی بر هوش مصنوعی را تقویت کنند.

دانشمندان در مقاله منتشر شده پیرامون روش اتخاذ شده خود توضیح میدهند که طراحی CPU «فقط از مشاهدات ورودی-خروجی خارجی به جای روش طراحی کد برنامه معمول شکل گرفته است». جالب است بدانید که بنابر ادعای محققان چینی، دقت پردازنده طراحی شده در حد 99.99999999999 درصد بوده که در نوع خود تحسین برانگیز است.

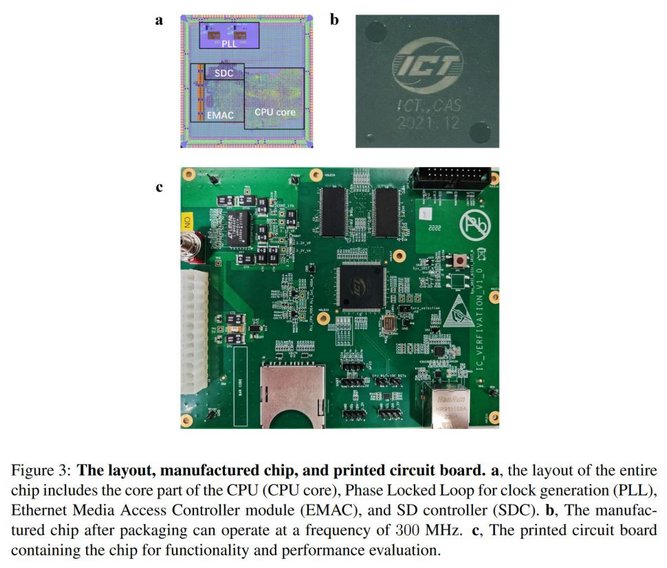

با استفاده از فرآیند ذکر شده در بالا، یک طراحی خودکار هوش مصنوعی از یک CPU ایجاد شده است. این پردازنده که از مجموعه دستورالعمل RISC-V32IA استفاده میکند برای ساخت تحت فناوری ساخت 65 نانومتری توسعه یافته که حداکثر فرکانس کار آن نیز تا 300 مگاهرتز اعلام شده است.

در نهایت دانشمندان موفق شدهاند سیستم عامل لینوکس (هسته 5.15) و SPEC CINT 2000 را با موفقیت بر روی CPU تولید شده توسط هوش مصنوعی اجرا کنند که این مورد عملکرد صحیح طرح تولیدی را تایید میکند.

همانطور که عنوان شد در بنچمارکهای Drystone، پردازنده ساخته شده نهایی عملکردی برابر با پردازنده قدیمی i486 داشته. جالب اینجاست که به نظر می رسد در همان آزمایش کمی سریعتر از Acorn Archimedes A3010 باشد که سالها پیش رقیب شماره یک کامپیوترهای آمیگا بود.

به هر حال باید گفت که فارغ از توان پردازشی حاصل شده در این روش، ظاهراً بیشتر اهداف حول نشان دادن قدرت هوش مصنوعی در طراحی یک ماشین پردازشی مانند سیستم خود بوده است. در واقع دانشمندان میتوانند این ایده را دنبال کنند که چطور میتوان هوش مصنوعی را توسعه داد که بتواند یک پردازنده مشابه خود تولید کنند.

اگر به یاد داشته باشید، دو سال پیش بود که گروهی از محققان در شرکت گوگل موفق به طراحی یک پردازنده هوش مصنوعی شدند که به لطف یک مدل هوش مصنوعی دیگر توسعه داده شده بود. با توجه به این ایده و اخباری که نشان میدهد حتی شرکتهایی مانند Nvidia از هوش مصنوعی برای بهینه سازی طراحی تراشه ها، استفاده میکنند، شاید بتوان به چنین طرحهایی امید بسیار بیشتر از طرحهای عملی تخیلی داشت. محض اطلاع باید در نظر داشته باشید که سال گذشته همچنین اعلام شد که نرمافزار DSO.ai به عنوان یک مدل هوش مصنوعی پیشرفته در بیش از 200 طرح تراشه مشتری استفاده شده است.

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت