نتایج یک مطالعه محدودیتهای جدیدی را درباره مدلهای هوش مصنوعی مانند ChatGPT آشکار کرده است. به نظر میآید مدلهای هوش مصنوعی تمایل چندانی به آموزش دیدن ندارند و در صورتی که یک موضوع بیش از پنج بار به آنها آموزش داده شود، رفتار عجیب و غریبی از خود بروز داده و به اصطلاح دیوانه (MAD) میشوند.

پژوهشگران دانشگاه استنفورد با مطالعه روی رفتار مدلهای هوش مصنوعی مانند ChatGPT به نتایج جالبی رسیدهاند. ظاهراً مدلهای هوش مصنوعی در هنگام آموزش دیدن رفتارهای عجیب و غریبی را از خود نشان میدهند.

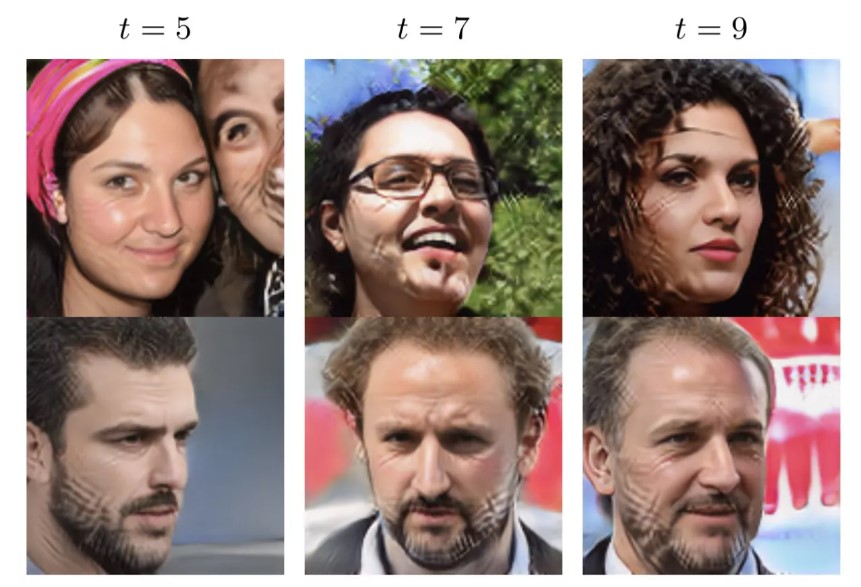

به نظر میآید اگر مدل هوش مصنوعی را بیش از پنج دوره با یک مطلب آموزش دهید، رفتار آنها تغییر کرده و مانند تصویر زیر خروجیهای غیر واقعی تولید میکنند. در این مواقع هوش مصنوعی به اصطلاح دیوانه یا MAD میشود.

عواقب خطرناک رفتارهای غیر منطقی هوش مصنوعی

بر اساس اعلام tomshardware همچنین ممکن است مدل های هوش مصنوعی دادههای مصنوعی تولید کرده و تصمیمات متعصبانه بگیرند. البته چنین رویکردی در رفتار هوش مصنوعی پس از پنج دوره آموزش نمود پیدا میکند.

هنوز معلوم نیست که آیا همه مدلهای هوش مصنوعی چنین اختلال رفتاری را دارند یا خیر. وجود چنین نقصی در عملکرد مدلهای هوش مصنوعی ممکن است آسیبهای جبران ناپذیری را به همراه داشته باشد. خصوصاً که این روزها بیشتر کارهای انسان دارد به هوش مصنوعی محول میشود.

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت