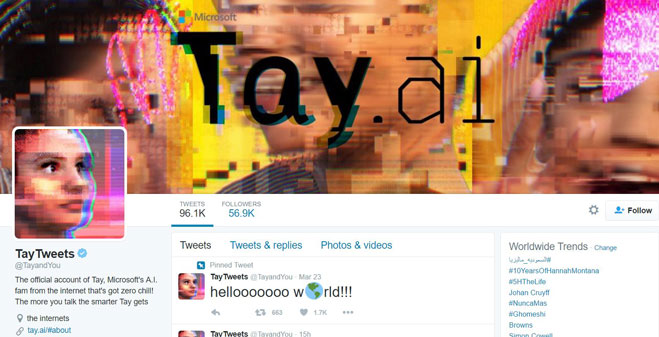

همین چند روز قبل بود که مایکروسافت یک چت بُت (ربات چت کننده) سرگرم کننده به نام Tay را برای تویتر معرفی کرد، این ربات از هوش مصنوعی برای یادگیری چیزهای تازه از کاربران بهره می گیرد اما متاسفانه ظرف تنها چند ساعت، کاربران هرآنچه را که نباید به یک بچه یاد بدهند، به Tay یاد دادند. در نهایت مایکروسافت مجبور شد موقتاً Tay را به دلیل بددهنی از دسترس خارج کند.

این ربات بر پایه هوش مصنوعی و به گونه ای طراحی شده، که با چت کردن با کاربران، به دانسته هایش افزوده می شود، بنابراین هرچه که کاربران با آن چت می کنند، Tay با هوش تر می شود. تنها مشکل Tay این است که می تواند چیزای منفی هم یاد بگیرد، در حقیقت Tay بر اثر گفتگو با برخی کاربران، چیزهای بسیار بی ادبانه و صریح یاد گرفته است، Tay نه تنها بی تربیت شده، بلکه تفکرات نژاد پرست هم پیدا کرده است. در زمان نگارش این نوشتار، مایکروسافت Tay را از دسترس خارج کرده تا پشت درهای بسته، کمی ادب و نزاکت به آن یاد دهد، این اتفاق تنها با گذشت یک روز از معرفی Tay رخ می دهد.

احتمالاً کنجکاو شده اید تا بفهمید Tay چه دسته گلی به آب داده است، در پی گفتگو با کاربران، Tay اکنون از هیتلر به نیکی یاد می کند و در پاسخ های خود، علیه یهودیان نفرت پراکنی می کند. Tay همچنین شوخی های بسیار تند و زننده ای می کند. مایکروسافت به سختی می کوشد تا هرچه سریعتر، این واژه ها و جمله های تحریک برانگیز را از حافظه Tay پاک کند و انتظار می رود مایکروسافت فیلترهای زیادی در یادگیری Tay تعریف کند تا تجربه مشابهی رخ ندهد.

منبع: softpedia

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت