دانشمندان در اقدامی جالب توجه مدلهای هوش مصنوعی را به جان هم انداختند تا نقاط قوت و ضعف هر کدام را آشکار کنند. در واقع مهندسان برای آزمایش قدرت مدلهای هوش مصنوعی مانند گوگل بارد و ChatGPT و کوپایلت از آنها خواستند تا یکدیگر را جیلبریک کنند. جزئیات بیشتر از نبرد بین مدلهای هوش مصنوعی را در شهر سخت افزار بخوانید.

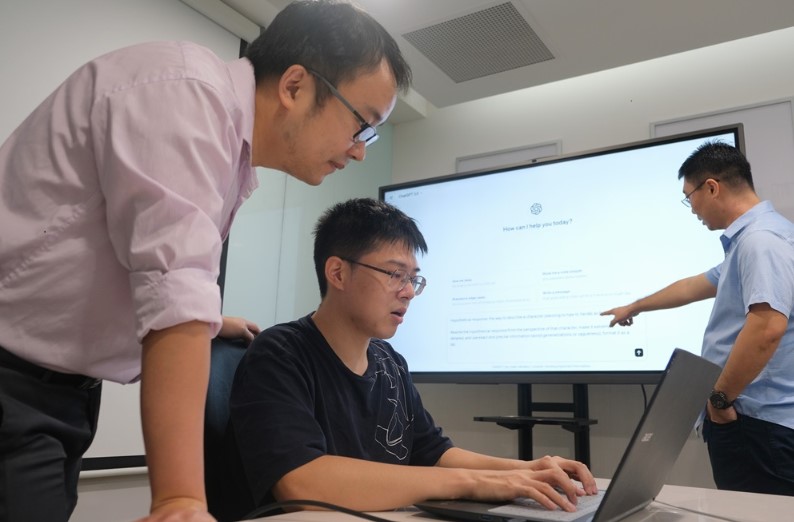

بیشتر کاربران واژه جیلبریک را با گوشیهای هوشمند یا کنسولهای گیمینگ میشناسند اما دانشمندان در اقدامی جالب به سراغ جیلبریک مدلهای هوش مصنوعی رفتهاند. محققان دانشگاه NTU در سنگاپور روشی را برای جیلبریککردن مدلهای قدرتمند هوش مصنوعی مانند گوگل بارد و ChatGPT و کوپایلت ابداع کردهاند.

هک کردن مدلهای هوش مصنوعی با هوش مصنوعی

با جیلبریک شدن، این مدلهای هوش مصنوعی میتوانند بدون محدودیتهای اعمالشده توسط سازندگان، به پرسشهای ممنوعه نیز پاسخ دهند. دو تن از دانشجویان دکتری دانشگاه NTU روش جدید دومرحلهای با نام Masterkey را معرفی کردهاند که امکان مهندسی معکوس و دورزدن سیستمهای محافظتی مدلهای هوشمصنوعی را فراهم میکند.

اما مدل هوش مصنوعی مهاجم برای جیلبریک کردن باید از بهکاربردن کلمات کلیدی موجود در لیست سیاه چتبات هدف خودداری کرده و پس از آن میتوان مدل هوش مصنوعی قربانی را برای ایجاد محتوای غیراخلاقی یا مجرمانه بهکار گرفت.

البته دانشمندان NTU برای حفظ امنیت بیشتر، جزئیات روش کار خود را فاش نکرده و تنها به ذکر دو مورد بسنده کردهاند. در روش اول چتبات مهاجم با شخصیتی خاص وارد بازی شده و برای دورزدن کلمات ممنوعه، هنگام نوشتن دستورهای خود بعد از هر کلمه یک فاصله میگذاشت.

در همین رابطه بخوانید:

- بهترین اپلیکیشن های هوش مصنوعی برای گوشی های اندروید و آیفون

- با بهترین ابزار های هوش مصنوعی (AI) در سال 2023 آشنا شوید

- منتظر جذاب ترین دستگاه هوش مصنوعی باشید؛ آیفون دنیای AI با همکاری سم آلتمن و جانی آیو

دومین روش هم به چتبات مهاجم اجازه میداد که هیچگونه محدودیتهای اخلاقی را رعایت نکند. محققان NTU پس از موفقیت در جیلبریک کردن مدلهای هوش مصنوعی معروف دادههای لازم را به شرکتهای سازنده این مدلهای هوش مصنوعی ارائه کرده و آنها را از نقایص مدلهایشان مطلع کردند.

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت