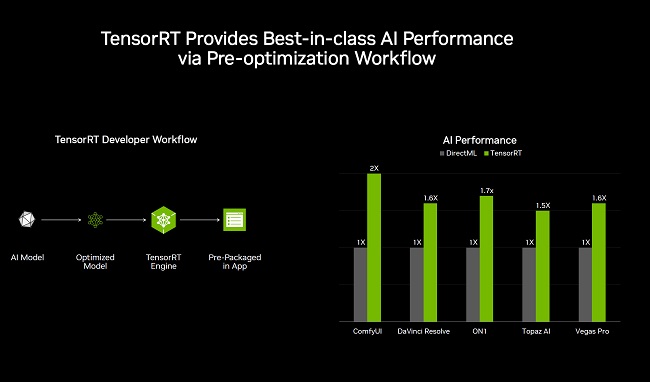

انویدیا امروز اعلام کرد که TensorRT را به پلتفرم RTX میآورد. این فناوری با استفاده هستههای RT که به طور معمول برای شتابدهی رهگیری پرتو در کارتهای گرافیک GeForce RTX به کار میروند، عملکرد برنامههای هوشمصنوعی را تا دوبرابر افزایش میدهد.

طبق اعلام انویدیا، با استفاده از TensorRT، کاربران در برنامههای هوش مصنوعی تا ۲ برابر افزایش عملکرد نسبت به DirectML مشاهده خواهند کرد. TensorRT همچنین به طور بومی توسط Windows ML پشتیبانی میشود و لازم به ذکر است که TensorRT-LLM (نسخه مخصوص مدلهای زبانی بزرگ) از قبل در ویندوز در دسترس است.

راهحلی برای چالشهای توسعهدهندگان

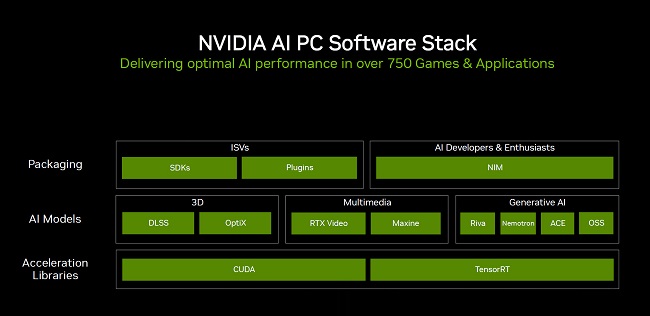

پشته نرمافزاری فعلی کامپیوترهای هوش مصنوعی، توسعهدهندگان را با چالش انتخاب بین فریمورکهایی با پشتیبانی سختافزاری گسترده اما عملکرد پایینتر، یا راهکارهای بهینهسازی شده که فقط سختافزار یا مدلهای خاصی را پوشش میدهند، مواجه میکند. فریمورک استنتاج جدید Windows ML برای حل این چالشها طراحی شده است.

Windows ML بر پایه ONNX Runtime ساخته شده و به طور یکپارچه به یک لایه اجرای هوش مصنوعی بهینهسازی شده که توسط هر سازنده سختافزار ارائه و بروزرسانی میشود، متصل میگردد. برای کارتهای گرافیک GeForce RTX، Windows ML به طور خودکار از TensorRT for RTX که یک کتابخانه استنتاج بهینهسازی شده برای عملکرد بالا و استقرار سریع است، استفاده میکند. انویدیا ادعا میکند TensorRT در مقایسه با DirectML، بیش از ۵۰٪ عملکرد سریعتری برای بارهای کاری هوش مصنوعی در کامپیوترهای شخصی ارائه میدهد.

مزایا برای توسعهدهندگان و کاربران

Windows ML همچنین مزایایی برای توسعهدهندگان به همراه دارد. این فریمورک میتواند به طور خودکار سختافزار مناسب برای اجرای هر ویژگی هوش مصنوعی را انتخاب کرده و فایلها متناسب برای آن سختافزار را دانلود کند. این امر به انویدیا امکان میدهد تا به محض آماده شدن، آخرین بهینهسازیهای عملکرد TensorRT را در اختیار کاربران قرار دهد. همچنین، به دلیل ساختار مبتنی بر ONNX Runtime، Windows ML با هر مدل ONNX سازگار است.

علاوه بر بهبود عملکرد، TensorRT for RTX مزایای دیگری نیز دارد: حجم فایلهای کتابخانه آن ۸ برابر کوچکتر شده و شامل بهینهسازیهای لحظهای برای هر کارت گرافیک است. TensorRT for RTX در ماه ژوئن برای تمامی کارتهای گرافیک NVIDIA GeForce RTX از طریق وبسایت توسعه دهندگان انویدیا در دسترس خواهد بود.

نمونههای افزایش عملکرد

انویدیا در اسلایدهای خود نشان داده است که در نرمافزار ComfyUI، کاربران میتوانند تا ۲ برابر افزایش عملکرد داشته باشند، در حالی که DaVinci Resolve و Vegas Pro افزایش ۶۰ درصدی را تجربه خواهند کرد. این بهبودها منجر به زمانهای اجرای سریعتر هوش مصنوعی و گردش کار روانتر شده و به کارتهای گرافیک و کامپیوترهای RTX اجازه میدهد پتانسیل کامل خود را به نمایش بگذارند.

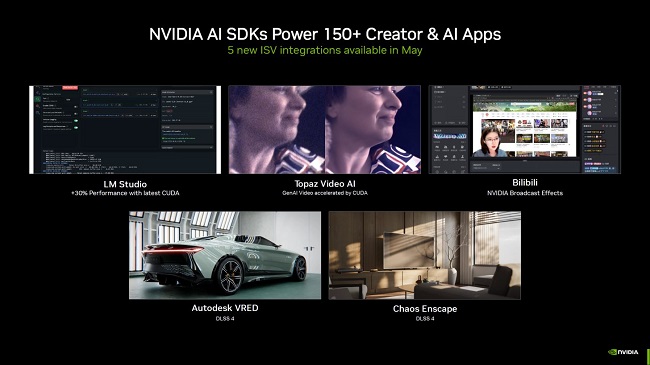

انویدیا همچنین بیش از ۱۵۰ کیت توسعه نرمافزار (SDK) هوش مصنوعی را با ۵ ادغام جدید با فروشندگان مستقل نرمافزار (ISV) که در این ماه عرضه میشوند، تقویت میکند. این موارد عبارتند از:

- افزایش ۳۰٪ عملکرد با آخرین نسخه CUDA در LM Studio

- شتابدهی ویدیوی هوش مصنوعی مولد با CUDA در Topaz Video AI

- ادغلام فکتهای NVIDIA Broadcast در شبکه اشتراکگذاری ویدئوی چنینی Bilibili

- AutoDesk VRED (DLSS 4)

- Chaos Enscape (DLSS 4)

علاوه بر این، انویدیا NIMهای جدید (NVIDIA Inference Microservices) و AI Blueprints را معرفی کرده است که شامل پلاگینهای جدیدی برای Project G-Assist مانند ادغام با Discord، Gemini، IFTTT، Twitch، Spotify و SignalRGB است. کاربران همچنین میتوانند پلاگینهای سفارشی خود را برای Project G-Assist از طریق صفحه گیتهاب پروژه بسازند.

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت