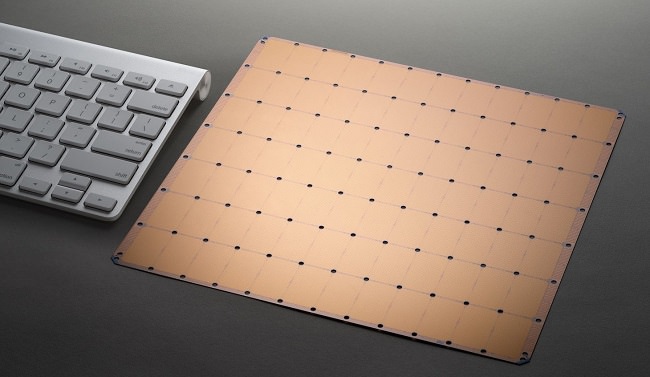

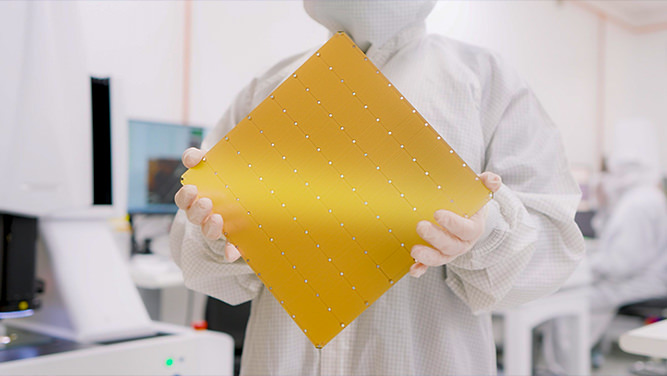

ظهور هوش مصنوعی نیاز ما به افزایش قدرت محاسباتی را دو چندان برجسته کرده است. در این راستا نیز شاهد معرفی پردازندههای جدیدی هستیم که صرفاً با هدف استفاده در صنعت AI رونمایی میشوند. با این حال، شرکت Cerebras Systems از یک تراشه 900 هزار هستهای به اندازه یک ویفر رونمایی کرده که میتواند به تنهایی معادل 62 پردازنده گرافیکی H100 انویدیا عمل کند.

شرکت Cerebras Systems از یک تراشه پیشرفته غول پیکر به نام Wafer Scale Engine 3 (یا WSE-3) رونمایی کرده که عملکردی دو برابری نسبت مدل قبلی خود یعنی WSE-2 در زمینه هوش مصنوعی دارد.

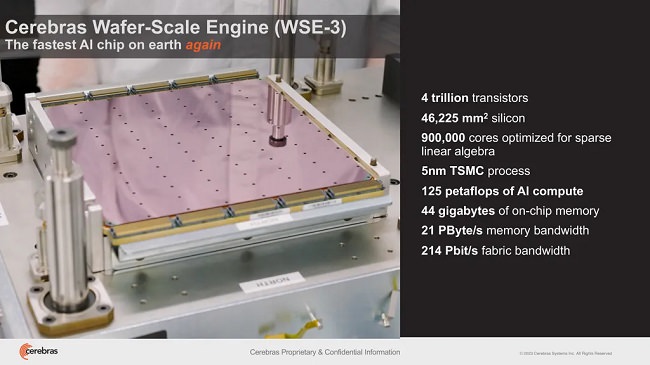

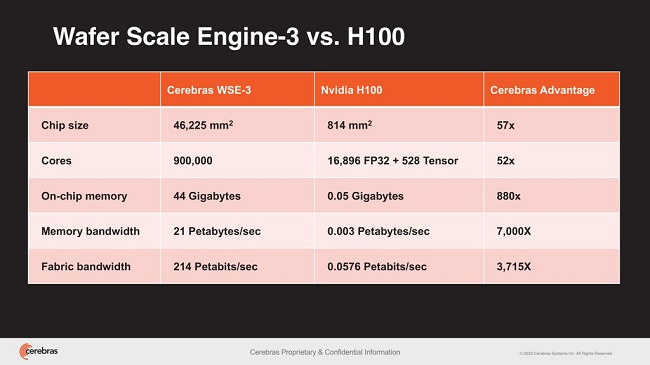

تازهترین تراشه معرفی شده توسط این شرکت 4 میلیون ترانزیستور تولید شده با فرایند ساخت کلاس 5 نانومتری TSMC را به همراه دارد. این تراشه 900 هزار هستهای هوش مصنوعی به 44 گیگابایت حافظه SRAM مجهز شده و میتواند حداکثر عملکرد 125 FP16 PetaFLOPS را در اختیار ما قرار دهد.

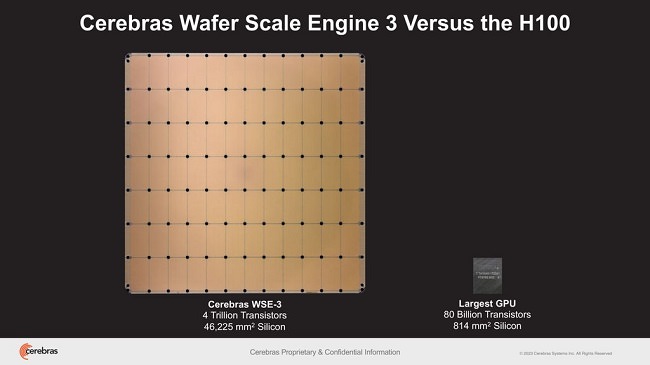

این رقم به معنای قدرت محاسباتی 62 برابری این پردازنده غولپیکر نسبت به پردازنده گرافیکی H100 انویدیا است که به عنوان قدرتمندترین پردازنده هوش مصنوعی در دسترسی قرار دارد.

آموزش قدرتمندترین مدلهای هوش مصنوعی با WSE-2

به گفته سخنگوی شرکت Cerebras Systems، از این تراشه غول پیکر برای آموزش برخی از بزرگترین و پیشرفتهترین مدلهای هوش مصنوعی صنعت AI استفاده خواهد شد.

علاوه بر این، گفته شده که WSE-3 قرار است در ابر کامپیوتر CS-3 مورد استفاده قرار گرفته و از آن برای آموزش مدلهای هوش مصنوعی با حداکثر 24 تریلیون پارامتر استفاده شود. این رقم یک جهش قابل توجه نسبت به ابر رایانههای مجهز به WSE-2 و دیگر پردازندههای AI مدرن محسوب میشود.

به گزارش Tomshardware، نکته جالب آن است که این سوپر کامپیوتر میتواند از 1.5 ترابایت، 12 ترابایت یا 1.2 پتابایت حافظه خارجی پشتیبانی کند که به آن اجازه میدهد مدلهای هوش مصنوعی عظیم را در یک فضای منطقی واحد و بدون پارتیشنبندی یا تغییر فاکتور ذخیره کند. این ویژگی فرایند آموزش AI را سادهتر کرده و کارایی توسعهدهندگان آن را بهبود میبخشد.

از نظر مقیاسپذیری، ابر کامپیوتر CS-3 را میتوان در خوشههایی (کلاستر) با حداکثر 2048 سیستم پیکربندی کرد. چنین مقیاسپذیری به ابر کامپیوتر مورد بحث اجازه میدهد تا 70 میلیارد مدل پارامتر را تنها در یک روز و چهار پیکربندی سیستمی تنظیم کند. به عبارت دیگر، این سیستم میتواند مدل زبانی Llama 70B (که در زمینه برنامهنویسی تخصص دارد) را از ابتدا به صورت کامل آموزش دهد.

در همین رابطه بخوانید:

- آزمایش دیوانهوار کارت 42 هزار دلاری H100 انویدیا در گیمینگ

- بنچمارک پردازنده گرافیکی H100 انویدیا؛ تا 4.5 برابر سریعتر از A100

جدیدترین چهارچوب نرمافزار شرکت Cerebras نیز پشتیبانی محلی PyTorch 2.0 و پراکندگی پویا و بدون ساختار را به همراه دارد که نتیجه آن آموزش سریعتر مدلهای هوش مصنوعی (تا هشت برابر سریعتر از روشهای سنتی) خواهد بود.

نظر خود را اضافه کنید.

برای ارسال نظر وارد شوید

ارسال نظر بدون عضویت در سایت